반응형

- Paper: https://eureka-research.github.io/assets/eureka_paper.pdf

- 프로젝트 페이지: https://eureka-research.github.io/

- 깃허브: https://github.com/eureka-research/Eureka

0. Abstract

- 대형 언어 모델 (Large Language Model, LLM)은 순차적 의사 결정 문제를 위한 high-level semantic 플래너로서 좋은 성능을 보임

- 그러나 펜돌리기 같은 복잡한 low-level의 제어 문제를 학습하는데 LMM을 활용하는 것은 아직 해결되지 않은 문제

- 이런 근본적인 차이를 해결하기 위해 EUREKA 기법을 제안 → LLM을 통한 사람 수준의 보상 디자인 알고리즘

- EUREKA는 뛰어난 제로샷 생성, 코드 작성, in-context 개선 능력이 있는 GPT-4와 같은 최신 LLM을 사용하여 보상 코드 작성에 대한 진화적 (evolutionary) 최적화를 수행

- 해당 보상은 강화학습을 통해 복잡한 능력을 취득하는데 사용될 수 있음

- 특정 문제에 특화된 프롬프팅이나 사전에 정의된 보상 템플릿 없이 EUREKA는 전문가 사람이 작성한 보상을 뛰어넘는 보상함수를 생성

- 10가지의 독특한 로봇 문제를 포함한 29개의 다양한 오픈 소스 RL 환경에서 EUREKA는 83%의 문제에 대해 사람 전문가를 능가하며 평균적으로 52%의 정규화 된 개선을 달성

- EUREKA의 일반성은 RLHF (Reinforecment Learning from Human Feedback)에 대한 새로운 gradient-free in-context 학습 접근을 가능하게 함 → 사람 입력을 통합하여 모델 업데이트 없이 생성된 보상의 품질과 안전성을 개선

- 커리큘럼 학습에서 EUREKA을 사용하여 처음으로 시뮬레이션 Shadow Hand가 펜 돌리기 문제를 수행할 수 있도록 함 → 빠른 속도로 원을 그리며 펜을 능숙하게 조작하는 문제

1. Introduction

- 대형 언어 모델 (Large Language Model, LLM)은 순차적 의사 결정 문제를 위한 high-level semantic 플래너로서 좋은 성능을 보임

- 반면 강화학습 (Reinforcement Learning, RL)은 제어 문제 뿐 아니라 다양한 분야에 있어 인상적인 결과들을 달성

- 단, 사람 디자이너가 원하는 행동을 도출할 수 있도록 정확하게 코드를 작성하고 주의깊게 보상함수를 정의하는 경우

- 이런 근본적인 중요성에도 불구하고 보상함수는 디자인하기 어려운 것으로 악명이 높음

- 최근 설문에 따르면 강화학습 연구자 및 실무자의 92%가 보상 함수에서 시행착오를 보고했으며 89%는 설계한 보상이 최적이 아니고 의도하지 않은 행동을 수행한다고 밝힘

- 이에 따라 본 논문에서는 GPT-4와 같은 최신 코딩 LLM을 사용하여 범용적인 보상 프로그래밍 알고리즘을 개발하는 것이 가능할지 살펴봄

- 이상적으로 보상 디자인 알고리즘은 다음과 같은 사람 수준의 보상 생성 능력을 달성해야함

- 넓은 범위의 문제로 확장될 수 있음

- 사람의 감독 없이 지루한 시행 착오 과정을 자동화

- 안전과 alignment를 보장하기 위해 사람의 감독과 호환되어야 함

- 이상적으로 보상 디자인 알고리즘은 다음과 같은 사람 수준의 보상 생성 능력을 달성해야함

- 본 논문은 Evolution-driven Universal REward Kit for Agent (EUREKA) 알고리즘을 제안 → 코딩 LLM을 기반으로 하는 새로운 보상 디자인 알고리즘

- Contributions

- 10가지의 독특한 로봇 문제 (quadruped, quadcopter, biped, manipulator, dexterous hands 등… 그림 1 참고)를 포함한 29개의 다양한 오픈 소스 RL 환경에서 사람 수준의 보상 디자인 성능 달성

- 특정 문제에 특화된 프롬프팅이나 사전에 정의된 보상 템플릿 없이 EUREKA는 자동으로 보상을 생성 → 83%의 문제에 대해 사람 전문가를 능가하며 평균적으로 52%의 정규화 된 개선을 달성

- 기존 수동 보상 엔지니어링으로는 해결이 불가능했던 정교한 제어 작업 해결

- 5개의 손가락을 가진 손이 펜을 최대한 많이 회전시키는 펜 돌리기 문제를 고려

- EUREKA를 커리큘럼 학습과 결합하여 처음으로 펜 돌리기를 simulated anthromorphic Shadow Hand (그림 1 하단 참고)에서 수행

- 다양한 사람 입력을 기반으로 더욱 성능이 뛰어나고 사람과 align된 보상함수를 생성할 수 있는 새로운 gradient-free in-context learning 기법을 RLHF에 적용

- EUREKA가 기존의 사람 보상 함수에 비해 더 개선될 수 있음을 보임

- 유사하게 사람의 피드백을 통해 에이전트의 행동에 대한 사람의 선호를 파악하고 보상함수 디자인을 보조할 수 있는 EUREKA의 능력도 선보임

- 10가지의 독특한 로봇 문제 (quadruped, quadcopter, biped, manipulator, dexterous hands 등… 그림 1 참고)를 포함한 29개의 다양한 오픈 소스 RL 환경에서 사람 수준의 보상 디자인 성능 달성

- 기존에 LLM을 사용하여 보상 디자인을 하는 L2R과 다르게 EUREKA는 완전히 문제 특화 프롬프트나 보상 템플릿, 퓨샷 예시 등을 사용하지 않음

- EUREKA가 자유롭고 표현력이 풍부한 보상 프로그램을 생성하고 개선할 수 있는 능력을 통해 명확하게 L2R의 성능을 뛰어넘음

- EUREKA의 일반성은 3가지 핵심 알고리즘 디자인 선택을 가능하도록 함

- 컨텍스트로서의 환경 (environment as context)

- EUREKA는 환경 소스 코드를 컨텍스트로 사용하여 제로샷으로 보상 함수 생성 가능

- 진화적 탐색 (evolutionary search)

- 반복적으로 보상함수의 후보에 대한 배치를 제안하고 가장 유망한 보상함수를 정제

- 보상 성찰(reward reflection)

- In-context 방식으로 성찰을 수행 → 정책 학습 통계에 기반한 보상 품질의 텍스트 요약으로 자동화되고 타겟팅 된 보상 편집을 가능하게 함

- 그림 3은 EUREKA의 제로샷 보상 및 최적화 과정 중에서 성찰이 누적되는 것의 예시

- 컨텍스트로서의 환경 (environment as context)

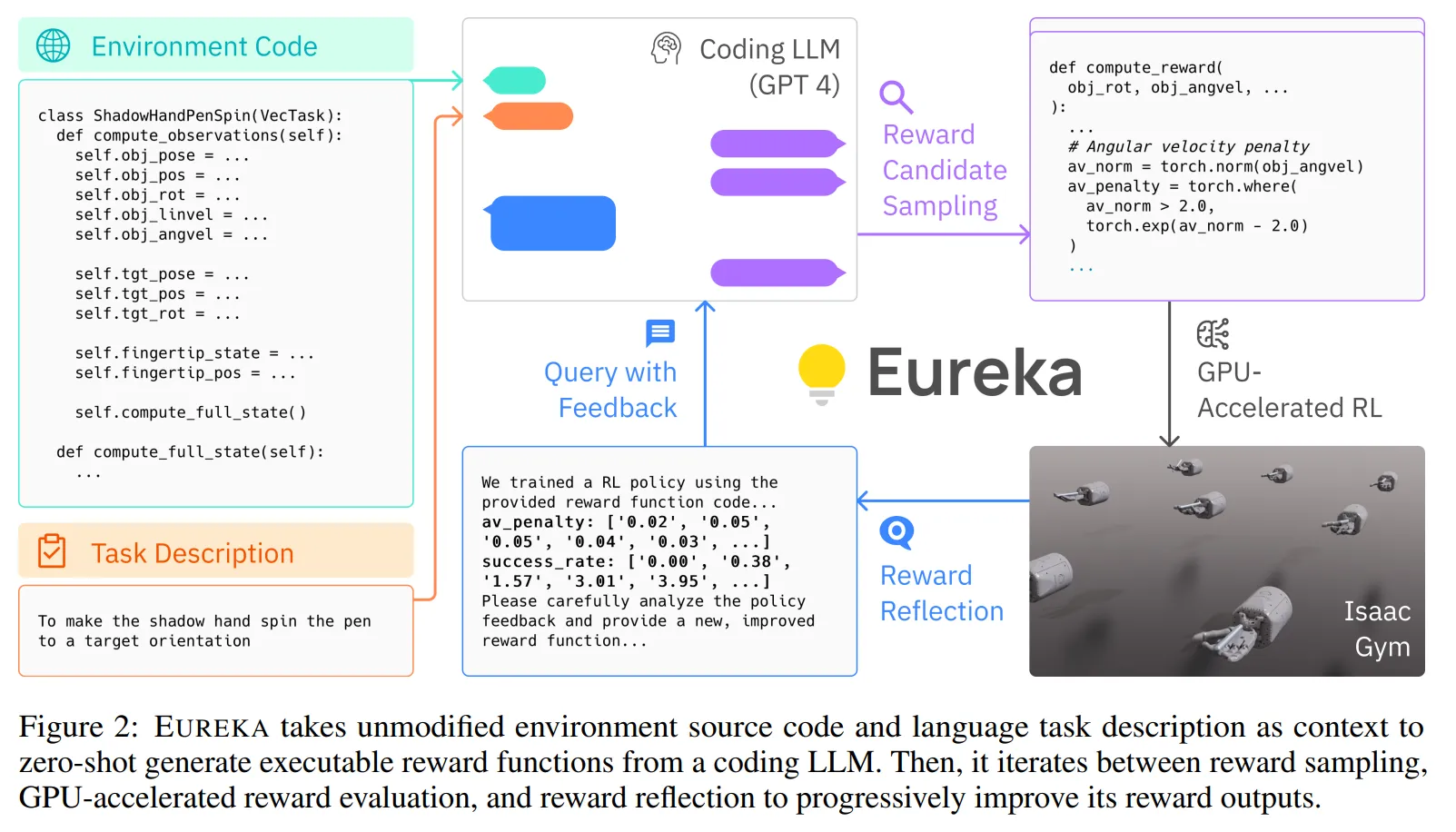

- 그림 2를 통해 EUREKA의 전반적인 개요를 살펴볼 수 있음

2. Problem Setting and Definitions

- 보상 디자인의 목표는 직접적으로 최적화하기 어려운 실제 보상을 형상화하는 보상 함수를 반환하는 것

Definition 2.1.

- RDP (Reward Design Problem)은 튜플 $P=<M, \mathcal{R}, \pi_M, F>$로 정의할 수 있음

- $M=(S,A,T)$는 상태 공간 $S$, 행동 공간 $A$, 전이 함수 (Transition function) $T$로 구성된 월드 모델

- $\mathcal{R}$은 보상 함수 공간; $\mathcal{A}_M(\cdot):\mathcal{R} \rightarrow \Pi$는 보상 함수 $R \in \mathcal{R}$을 최적화하는 정책 $\pi:S \rightarrow \triangle(A)$를 출력하는 학습 알고리즘

- $F:\Pi \rightarrow \mathbb{R}$은 적합성 (fitness) 함수로 정책에 대해서 스칼라 값으로 평가를 생성 → 정책 쿼리를 통해서만 접근 가능 (i.e. 적합성 함수를 통해 정책 평가)

- RDP의 목표는 정책 $\pi:=\mathcal{A}_M(R)$이 $R$을 최적화하여 가장 높은 적합성 점수 $F(\pi)$를 달성할 수 있도록 보상 함수 $R \in \mathcal{R}$을 출력하는 것

Reward Generation Problem

- 본 문제 세팅에서는 모든 RDP의 요소가 코드를 통해 정의

- 문제를 정의하는 문자열 $l$이 주어졌을 때 보상 생성 문제의 목표는 $F(\mathcal{A}_M(R))$을 최대화하는 보상 함수 코드 $R$을 출력하는 것

3. Method

- EUREKA는 3개의 알고리즘적 요소로 구성됨

- 환경을 컨텍스트로 사용하여 실행 가능한 보상 함수가 제로샷으로 생성될 수 있게 함

- 반복적으로 보상 함수 후보를 제안하고 정제하는 진화적 탐색

- 세부적으로 보상 함수를 개선하는 보상 성찰

- 수도 코드는 Alg. 1 참고 → 모든 프롬프트는 부록 A 참고

3.1. Environment as Context

- 보상 디자인을 위해 환경에 대한 스펙이 LLM에 제공되어야 함

- 이에 따라 직접적으로 원본 환경 코드 (보상 코드 제외)를 컨텍스트로 제공

- 이는 2가지 측면에서 직관적

- 코딩 LLM은 프로그래밍 언어로 작성된 코드 자체를 통해 학습됨 → 이에 따라 그들이 학습된 스타일과 문법으로 구성된 데이터를 직접적으로 사용할 때 코드 생성 능력이 더 강해짐

- 더 기본적으로 환경 소스 코드는 환경이 의미적으로 무엇을 포함하는지, 특정 문제에 대해 보상 함수를 구성하는데 어떤 변수를 사용해야하고 사용할 수 있는지 보여줌

- EUREKA는 코딩 LLM이 일반적인 보상 디자인과 포맷 팁만을 사용하여 직접적으로 실행가능한 파이썬 코드를 반환하게 함

- 또한 이런 최소한의 명령만 사용하여 EUREKA는 첫 시도만에도 다양한 환경에서 그럴듯해 보이는 보상 함수를 제로샷으로 생성

- EUREKA 출력의 예시는 그림 3 참고

- 살펴본 것과 같이 EUREKA는 제공된 환경 코드에 존재하는 관측 변수 (e.g. 손가락 끝 위치)를 사용하고 환경 특화 프롬프트 엔지니어링이나 보상 템플릿 없이도 적절한 보상 코드를 생성

- 그러나 첫 시도에서 생성된 보상함수가 항상 실행되는 것은 아님 그리고 만약 실행되더라도 이는 문제 적합성 지표 $F$에 비해 최적이 아닐 수 있음

- 프롬프트를 문제 특화 포맷으로 하거나 보상 디자인의 힌트를 줘서 개선할 수 있지만 이렇게 하는 경우 새로운 문제로 확장할 수 없고 시스템의 전반적인 일반성을 방해

- 어떻게 단일 샘플 보상 생성이 최적이 아닌 것을 효과적으로 극복할 수 있을까?

3.2. Evolutionary Search

- 어떻게 진화적 탐색이 앞에서 말한 실행 에러와 최적화 되지 않는 문제를 해결할 수 있는지 살펴보자

- 실행 에러 해결

- 각 반복마다 EUREKA는 LLM으로부터 몇몇의 독립적인 출력을 샘플링 (Alg. 1의 5줄 참고)

- 생성들이 i.i.d이므로 샘플의 수가 증가함에 따라 각 반복에서 모든 보상 함수에 버그가 있을 확률이 감소하게 됨

- 모든 환경에서 첫번째 반복에서도 적은 수 (16)의 출력만 샘플링해도 적어도 하나는 실행 가능한 보상 코드를 도출

- 실행 가능한 보상 함수가 초기 반복에서 주어지면 EUREKA는 in-context 보상 변형 (mutation)을 수행 → 텍스트 피드백에 기반하여 기존의 보상함수를 새로운 개선된 보상함수로 제안

- LLM이 instruction-following과 in-context 개선 능력이 있으므로 EUREKA는 정책 학습에 대한 텍스트 요약에 기반하여 기존 보상 코드를 수정하는 몇가지 일반적 방법을 제안하는 텍스트 프롬프트로 변형 연산자를 지정하여 이를 수행 → 보상 변형이 그림 3에서 시각화 됨

- 새로운 EUREKA 반복은 이전 반복에서 가장 뛰어난 성능을 보인 보상을 컨텍스트로 취하고 LLM의 출력으로 K개의 더 많은 i.i.d 보상함수를 생성

- 이 반복적인 최적화는 지정된 숫자만큼 반복을 수행

- 또한 다수의 랜덤 재시작을 통해 더 나은 전역 솔루션을 탐색 → 초기에 잘못된 추정을 극복하기 위한 전역 최적화의 일반적인 전략

- 본 실험에서 EUREKA는 환경 당 5개의 독립적인 실행을 수행하고 각 실행에서 5번 반복을 수행하며 반복당 K=16개의 샘플 사용

3.3. Reward Reflection

- in-context 보상 변형 수행을 위해 생성된 보상의 품질을 말로 표현할 수 있어야 함

- 결과 정책에 대해 문제 적합성 함수 $F$를 사용할 수 있지만 이는 단순히 보상 평가에 대한 수치적인 점수만 제공하는 단순한 전략

- 문제 적합성 함수 자체는 전체적인 실제 지표 역할을 하지만 보상 기능이 작동하는 이유에 대해 유용한 정보를 제공하지 않음

- 보상에 대해 더욱 복잡하고 타겟팅 된 진단 제공을 위해 정책 학습 역학을 텍스트로 요약하여 자동화된 피드백을 구축하는 방법 제안

- 학습 과정 중에 중간 정책 체크포인트에서 모든 보상 요소의 스칼라 점수를 추적

- 예를 들어 그림 2의 예시에서 av_penalty의 값은 보상 피드백에서 리스트로 제공됨

- 보상 성찰 과정은 구축하는 것은 단순하지만 알고리즘이 보상 최적화의 특성에 의존하므로 중요함

- 아무리 보상 함수가 효율적이어도 이는 특정 강화학습 알고리즘의 선택에 영향을 받으며 동일한 보상을 동일한 최적화기를 통해 사용하더라도 파라미터 차이에 의해 성능이 달라질 수 있음

- 개별 보상 요소에 대해 강화학습 알고리즘이 얼마나 최적화되는지 자세히 제공하므로써 보상 성찰은 EUREKA가 더욱 타겟화 된 보상 편집을 생성하며 생성된 보상함수가 고정된 강화학습 알고리즘과 더 잘 시너지가 나도록 함

4. Experiments

- EUREKA를 다양한 로봇 구현체와 문제에서 평가를 수행하여 보상 함수 생성, 새로운 문제 풀기, 다양한 형태의 사람 입력과 통합 등의 능력을 테스트

- Backbone LLM으로는 gpt-4-0314 사용

- 결과 비디오, 보상 예시, 오픈소스 코드 등은 모두 프로젝트 웹사이트에 공개: https://eureka-research.github.io/

환경

- 환경은 10개의 로봇, 29개의 Isaac Gym 시뮬레이터를 이용한 문제로 구성

- 먼저 9개의 Isaac Gym 기본 환경들은 quadruped, bipedal, quadrotor, cobot arm, dexterous hand 들로 구성

- 20개의 문제는 Bidexterous Manipulation (Dexerity) 벤치마크

- Dexerity 벤치마크는 한쌍의 Shadow Hand가 복잡한 제어 기술을 푸는 20개의 복잡한 문제

- 물건 건네기, 컵 180도 돌리기 등의 문제들 포함

- EUREKA의 문제 설명 입력을 위해서 환경에서 공식적으로 제공하는 설명을 사용 → App. B 참고

- 두 벤치마크들의 경우 GPT-4 공개 이후에 발표된 것들이므로 GPT-4가 해당 벤치마크에 대한 사전 지식을 가지고 있지 않음

4.1. Baselines

L2R

- L2R은 템플릿화 된 보상을 생성하기 위해 두 단계의 LLM 프롬프팅 기법 제안

- 첫번째 LLM은 환경과 문제에 대해 자연어로 설명하기 위해 에이전트의 동작을 묘사하는 내용으로 자연어 템플릿을 채우도록 함

- 두번째 LLM은 파라미터를 설정하는 보상 프로그램을 작성하기 위해 수동으로 정의된 보상 API 세트를 호출하여 이 “동작 묘사”를 코드로 변환

- 환경마다 5개의 독립적인 L2R을 실행하며 각 실행마다 16개의 보상 샘플을 생성 → 부록 C 참고

Human

- 원본 보상 함수는 벤치마크 문제에서 제공받음

- 해당 보상함수들은 해당 문제를 디자인 한 강화학습 연구자들에 의해 작성된 것으로 이 보상함수들은 전문가 수준 사람의 보상 엔지니어링 결과물

Sparse

- 생성된 보상의 품질을 평가하기 위해 사용하는 적합성 함수 $F$와 동일 → 이 또한 벤치마크에서 제공

- Dexterity 문제에서는 문제의 성공 여부를 특정하는 binary indicator 함수

- Isaac 문제에서는 문제의 종류에 따라 다양한 함수 형태를 가짐

- 부록 B 참고 → 모든 문제에 대한 정답 점수 기준 설명

4.2. Training Details

Policy Learning

- 모든 문제에 대해 최종 보상함수는 동일한 하이퍼파라미터로 설정된 동일한 강화학습 알고리즘을 통해 최적화

- Isaac과 Dexterity 모두 잘 튜닝된 PPO (well-tuned PPO) 구현 사용

Reward Evaluation Metrics

- Issac 문제에 대해서는 각 문제에 대해 메트릭 $F$가 값이 가지는 의미나 범위가 다양하므로 EUREKA와 L2R에 대해 human normalized score를 사용 → $\frac{Method - Sparse}{|Human - Sparse|}$

- 이는 정답 메트릭과 관련하여 EUREKA의 보상이 사람 전문가의 보상과 비교했을 때 어떻게 평가되는지에 대한 척도를 제공

- Dexterity에 대해서는 모든 문제가 이진 성공 함수를 사용하며 평가되므로 직접적으로 성공률을 사용

4.3. Results

EUREKA outperforms human rewards

- 그림 4에서 두 벤치마크에 대해 요약된 결과를 살펴볼 수 있음

- EUREKA가 모든 Isaac 문제와 20개의 Dexterity 문제 중 15개에서 사람 수준과 유사하거나 더 뛰어난 성능을 보임

- 반면 L2R은 낮은 차원의 문제 (e.g. CartPole, BallBalance)에서는 비교할만한 성능을 보였으나 고차원의 문제에서는 많이 성능이 떨어짐

- EUREKA는 아무런 도메인 지식 없이 자유로운 형태의 보상을 처음부터 생성하며 더욱 좋은 성능을 보임

- 부록 E를 참고하면 GPT-4를 GPT-3.5로 변경한 경우에도 성능 저하는 있지만 대부분의 Isaac 문제에서 여전히 사람과 유사하거나 더 뛰어난 성능을 보이는 것을 확인

EUREKA consistently improves over time

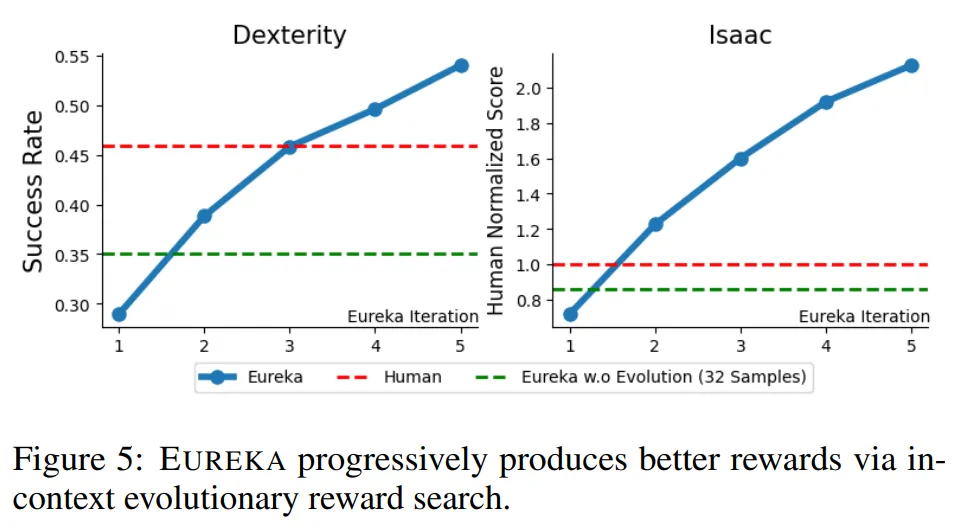

- 그림 5를 참고하면 각 진화 반복 후 EUREKA의 누적 최대 보상의 평균 성능 확인 가능

- 또한 ablation 스터디를 위해 EUREKA w.o. Evolution (32 Samples) 사용

- 이는 초기 보상 생성 스텝만 수행하는 대신 EUREKA의 두번째 반복까지 수행한 것과 동일한 수인 32개의 샘플링 수행

- 이는 반복적인 개선 없이 첫 보상 생성 시도를 통한 단순한 샘플링보다 EUREKA의 진화를 수행하는 것이 더 이득이라는 점을 보임

- 두 벤치마크 모두에서 보상이 점진적으로 개선되며 결과적으로 사람 보상을 능가

- 이런 지속적인 개선의 이점은 단순히 첫 반복에서 더 많은 샘플링을 수행하는 ablation의 결과가 EUREKA를 2번 반복한 후의 결과보다 모든 벤치마크에서 성능이 떨어진다는 것을 통해서도 확인할 수 있음

- 이를 통해 EUREKA의 새로운 진화 최적화 기법이 최종성능에 필수불가결 하다는 것을 알 수 있음

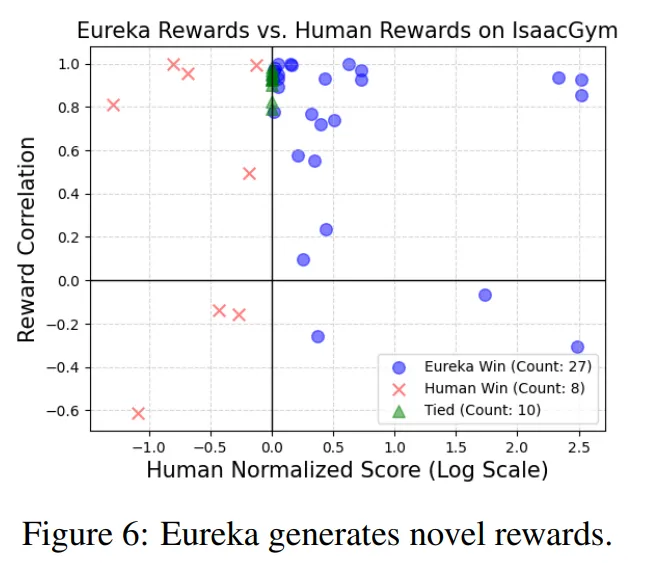

EUREKA generates novel rewards

- EUREKA 보상의 새로움을 평가하기 위해 모든 Isaac 문제에서 EUREKA와 사람 보상에 대한 상관관계 (correlation)을 계산 → 부록 B 참고

- 상관관계와 human normalized 점수에 대한 산점도를 나타낸 것이 그림 6과 같음

- 여기서 문제가 어려울수록 EUREKA 보상과 사람의 보상 간의 상관관계가 줄어드는 것을 확인할 수 있음 → 이는 사람의 보상이 어려운 문제에서는 최적이 아닐 수 있으며 EUREKA의 보상이 차별성이 있으며 더 좋다고 가정할 수 있음

- 또한 몇몇 경우에서는 EUREKA 보상이 사람 보상과 음의 상관관계를 가지는데도 훨씬 더 잘 문제를 수행하는 것을 확인할 수 있음 → 이를 통해 EUREKA가 사람의 직관과는 다른 새로운 보상 디자인을 발견한다는 것을 알 수 있음 (부록 F.2 참고)

Reward reflection enables targeted improvement

- 보상 피드백에서 보상 성찰 수행의 중요성을 평가하기 위해 ablation 수행 → EUREKA (No Reward Reflection) → 보상 피드백 프롬프트를 축소해서 오직 문제 메트릭 $F$의 값만 포함하도록 함

- 모든 Isaac 문제에 대해 평균했을 때 보상 성찰 없는 EUREKA는 평균 정규화 점수가 28.6% 감소

- 특히 차원이 높은 문제에 대해서는 더욱 큰 성능 저하가 발생

- 정성적인 분석에 대해서는 부록 F.1 참고

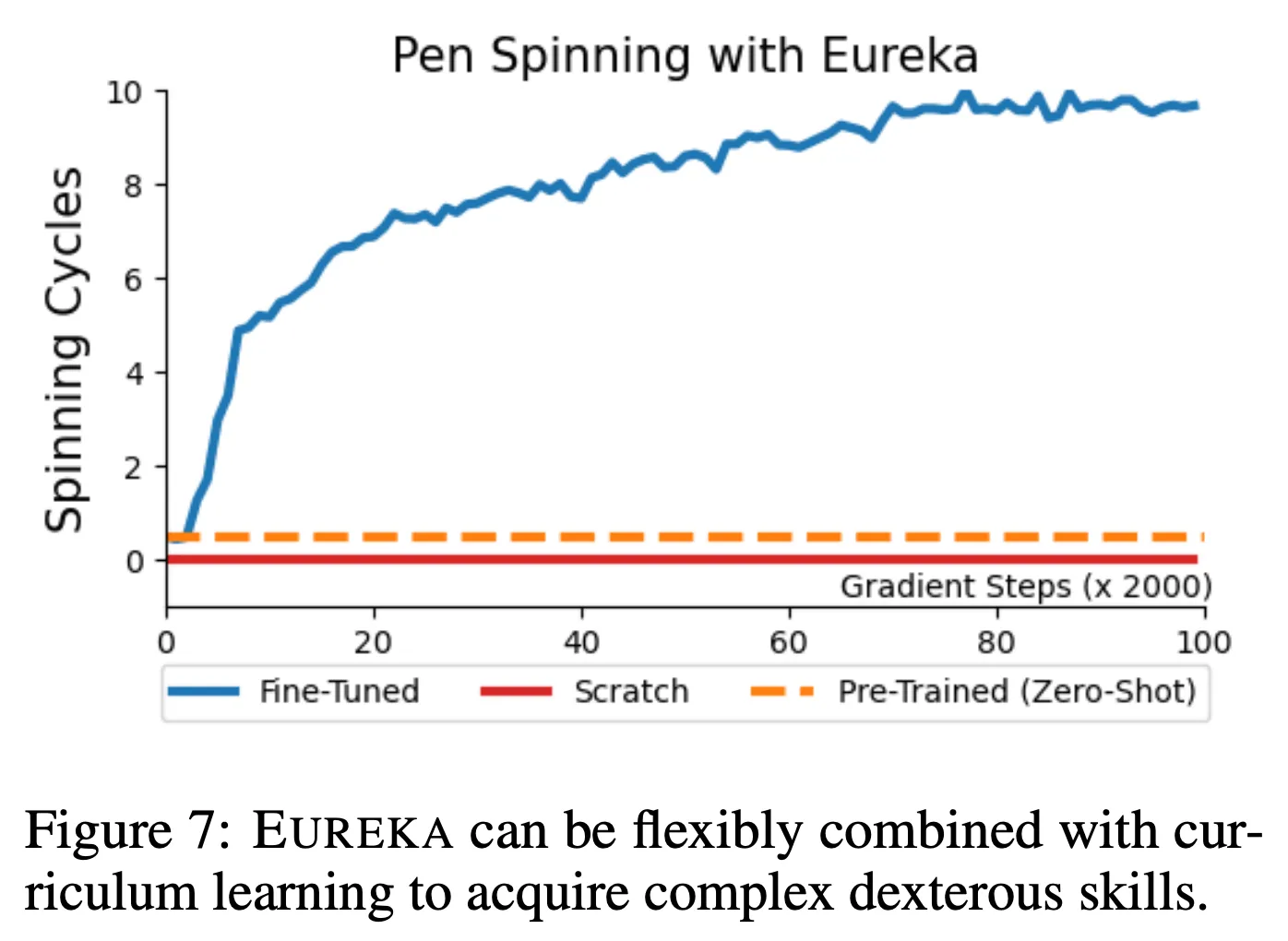

EUREKA with curriculum learning enables dexterous pen spinning

- EUREKA가 새롭고 도전적인 제어 문제를 푸는데 사용될 수 있을지 조사 → 펜 돌리기로 테스트

- 굉장히 동적인 문제로 Shadow Hand가 연속적으로 펜이 회전하도록 해야함

- 본 문제에 대해서 커리큘럼 학습 적용

- EUREKA가 문제를 독립적으로 풀 수 있도록 관리 가능한 요소로 문제를 나눔

- Pre-Trained: 먼저 EUREKA가 임의의 타겟 형상으로 펜을 재위치시키는 것에 보상 제공

- Fine-Tuned: 펜 돌리기 형상의 시퀀스에 도달하는 것에 보상을 주도록 파인튜닝

- EUREKA가 문제를 독립적으로 풀 수 있도록 관리 가능한 요소로 문제를 나눔

- Scratch: 위의 Pre-Trained 과정 없이 바로 처음부터 EUREKA를 사용하여 정책 학습

- 강화학습 학습 커브는 그림 7에서 살펴볼 수 있음

- EUREKA 파인튜닝은 빠르게 성공적으로 펜을 돌리는 정책을 달성

- 반면 Pre-Trained나 Scratch의 경우 한번 펜돌리기 사이클을 달성하는 것도 하지 못함

- EUREKA 파인튜닝 방식을 통해 다른 형상으로 펜 돌리기를 수행하는 다양한 펜 돌리기 정책 학습 수행

- 결과는 프로젝트 웹사이트에서 살펴볼 수 있으며 실험 상세 내용은 부록 D.1 참고

- 해당 결과들을 통해 EUREKA가 매우 복잡한 기술을 학습하는데 필요한 발전된 정책 학습에 사용될 수 있음

4.4. EUREKA From Human Feedback

- EUREKA는 새로운 gradient-free in-context 학습을 RLHF에 수행할 수 있음 → 다양한 종류의 사람 입력을 통해 더욱 성능이 좋고 사람과 일치된 보상 함수를 생성할 수 있음

EUREKA can improve and benefit from human reward functions

- 사람의 보상 함수로 초기화하여 시작하는 경우 EUREKA에 더욱 도움이 되는 것을 확인

- 사람의 보상함수를 단순히 EUREKA의 첫번째 반복의 출력으로 사용

- 이를 위해 기존 EUREKA와 사람 보상 사이에 상대 성능 차이가 있는 Dexterity의 몇가지 문제들을 선택

- 그림 8을 통해 결과 확인 가능

- 해당 결과에서 보듯이 사람의 보상 품질과 관계 없이 EUREKA는 사람의 보상으로부터 개선을 수행 → EUREKA (Human Init.)

- 일관적으로 모든 문제에 대해 EUREKA나 사람보다 좋은 성능을 보임

- 이를 통해 EUREKA의 in-context 보상 개선 능력은 기본 보상의 품질과 독립적이라는 것을 알 수 있음

- 해당 결과들은 EUREKA의 보상 생성 보조 능력을 보여줌 → 어떤 상태 변수가 유용한지 아는 사람 디자이너의 사전 지식을 통해 보상을 디자인

Reward reflection via human feedback induces aligned behavior

- 지금까지 모든 EUREKA 보상들은 고정된 블랙박스 형태의 문제 적합성 함수 $F$에 의해 최적화 됨

- 하지만 이 값은 사람의 의도를 반영하지 못하고 있을 가능성이 있음

- 또한 많은 실제 문제에서는 $F$를 사용할 수 없음

- 이에 따라 어려운 시나리오에서 인간이 개입하여 원하는 행동에 따라 보상 성찰을 텍스트로 표현하여 EUREKA 강화

- 부록 F. 4를 통해 사람의 피드백 시퀀스와 EUREKA 보상을 살펴볼 수 있음

- 하나는 사람 보상 성찰로 학습된 EUREKA-HF와 다른 하나는 일반 EUREKA 보상으로 학습된 에이전트를 통해 얻은 정책으로 랜덤한 비디오를 생성 한 후 20명의 일반 사용자에게 보여주고 선호를 조사

- 표 1을 참고하면 EUREKA-HF 에이전트가 사용자들에게 더욱 선호되는 것을 알 수 있음

- 그림 9를 통해 각 사람 피드백 이후에 EUREKA로 학습된 행동이 진화하는 것을 확인 할 수 있음

- 정성적으로 EUREKA-HF의 에이전트가 점진적으로 더 안전하고 안정된 걸음걸이를 수행

- 본 논문의 프로젝트 웹사이트를 통해 EUREKA-HF로 학습된 정책의 중간 과정들을 살펴볼 수 있음

5. Conclusion

- EUREKA 알고리즘 제안 → 코딩 대형 언어 모델과 in-context 진화 탐색 기법을 사용하는 범용적인 보상 디자인 알고리즘

- 문제에 특화된 프롬프트나 사람의 개입 없이 EUREKA는 다양한 범위의 문제에서 사람 수준의 보상 생성 달성

- EUREKA는 제어 학습에 강점을 보이는 알고리즘으로 처음으로 커리큘럼 접근을 통해 펜 돌리기 제어 문제를 해결

- 또한 EUREKA는 gradient-free 접근을 RLHF에 적용할 수 있음 → 사람 보상 초기화나 사람 텍스트 피드백을 통해 더 나은 보상 생성 가능

반응형

'논문 리뷰 > Reinforcement Learning' 카테고리의 다른 글

| Stop Regressing: Training Value Function via Classification for Scalable Deep RL (0) | 2024.11.22 |

|---|---|

| Guiding Pretraining in Reinforcement Learning with Large Language Models (1) | 2024.11.21 |

| Training Diffusion Models with Reinforcement Learning (2) | 2024.11.16 |

| Collaborating with Humans without Human Data (8) | 2024.11.15 |

| Deep Reinforcement Learning from Human Preference (3) | 2024.11.10 |