- Paper: https://arxiv.org/pdf/2210.10243.pdf

0. Abstract

- 강화학습 알고리즘은 일반적으로 샘플 비효율적 (sample inefficiency)이며 일반화가 어렵다고 알려짐

- 최근 Unsupervised Environment Design (UED)가 zero-shot 일반화를 위한 새로운 패러다임으로 떠오름 → task 분포의 학습과 샘플링 된 task 들에서의 에이전트 정책 학습을 동시에 수행

- 이는 고정되지 않은 (non-stationary) 과정으로 task 분포가 에이전트 정책과 함께 진화시킴

- 과거의 연구들을 통해 일반화에 대한 개선을 이뤘지만 아직 task 공간에 대한 샘플 효율성을 개선하지는 못했음

- 이에 따라 본 논문은 CLUTR 기법을 제안 → 새로운 커리큘럼 학습 알고리즘으로 task representation과 커리큘럼 학습을 두 단계의 최적화 과정으로 분리

- 먼저 latent task manifold 학습을 위해 무작위로 생성된 task에 대해 recurrent Variational Autoencoder (VAE)를 학습

- 다음으로 teacher 에이전트가 manifold로부터 샘플링 된 latent task의 세트에 대해 minimax REGRET 기반의 목적함수를 최대화하는 커리큘럼을 생성

- Task manifold를 고정하여 CLUTR가 성공적으로 non-stationary 문제를 극복하고 안정성을 개선하는 것을 확인

- 본 논문의 실험 결과는 어려운 환경인 CarRacing과 navigation 환경에서 검증

- CLUTR가 이론적으로 검증되었으며 널리 사용되는 UED 기법인 PAIRED를 일반화 및 샘플 효율성 측면에서 뛰어넘는 성능을 가지는 것을 보임

- F1 CarRacing 벤치마크에서 18배의 개선을 보임

- CLUTR는 또한 CarRacing에서 non-UED SOTA 기법과도 비교할만한 성능을 보임 → 20개 트랙 중 9개에서 더 뛰어난 성능을 보임

- CLUTR는 또한 PAIRED에 비해 18개의 out-of-distribution navigation 문제에서 33% 더 높은 성공률을 달성

1. Introduction

- 기존 강화학습의 단점

- 샘플 비효율적이며 일반화되지 않음: 학습 동안에 경험한 적 없는 task에 대해서는 나쁜 성능을 보이고 환경에 약간의 변화만 줘도 문제를 푸는데 실패하는 경우도 있음

- 커리큘럼 학습 (Curriculum Learning, CL)을 통해 강화학습에 대한 샘플 효율성을 향상 시킬 수 있는 가능성을 확인 → 에이전트의 능력의 경계에 해당하는 task에 대해 학습하는 teacher 알고리즘을 사용 → i.e. 에이전트가 현재 풀 수 있는 것보다 조금 더 어려운 task를 제안

- 최근에 Unsupervised Environment Design (UED)라고 하는 비지도 커리큘럼 알고리즘들이 연구되면서 일반화 성능에 대해 인상적인 향상이 이루어짐

- UED는 환경의 파라미터들 (e.g. 네비게이션 문제에서의 시작 지점, 골, 장애물 위치 등)을 자동적으로 샘플링하여 task를 생성 → 다양한 task 분포에 적응하면서 샘플 효율성과 일반화 성능을 향상시킴

- Protagonist Antagonist Induced Regret Environment Design (PAIRED)

- 가장 이론적으로 검증된 UED 알고리즘 중 하나

- PAIRED의 teacher 자체가 강화학습 에이전트로 행동이 다른 task 파라미터를 의미

- PAIRED는 에이전트의 regret을 최대로 하는 task를 생성 → 여기서 regret은 최적의 정책과 student 에이전트의 성능 차이를 의미

- 이론적으로 수렴시 에이전트는 regret을 최소화하도록 학습 → i.e. 풀 수 있는 모든 문제를 풀게됨

- 이런 강인성에 대한 보장은 regret 기반의 teacher가 강인한 에이전트 학습에 적절하도록 만들어줌

- PAIRED의 샘플 비효율성과 그 원인

- 이런 강력한 강인성 보장에도 불구하고 PAIRED는 여전히 실제로는 샘플 비효율적

- 이에 대한 원인은 regret 기반의 teacher를 학습하는 것이 어렵기 때문!

- 첫번째로 teacher는 task의 모든 파라미터를 구체화하고 난 후에 sparse 보상을 받음 → long-horizon credit assignment 문제 유발

- credit assignment 문제란? → Credit Assignment란, trajectory 중 어떤 step이 sum of discounted reward, 즉 return에 가장 많이 영향을 미쳤는지를 알아내는 문제 (참고)

- 추가적으로 teacher 에이전트는 파라미터 공간이 순열 불변 (permutation invariant)인 경우 조합 폭발 (combinatorial explosion) 문제가 발생

- 더욱 중요하게는 에이전트의 능력의 최전선에 있는 task의 생성을 위해서 teacher는 task manifold의 학습과 커리큘럼 유도를 위한 탐색을 동시에 수행해야 함

- Teacher는 regret에 기반하여 task manifold를 내재적으로 학습

- 그러나 student는 teacher와 함께 지속적으로 학습 → task manifold 또한 시간에 따라 진화함

- 그러므로 teacher는 task manifold의 진화에 대한 학습과 이를 효율적으로 탐색하는 방법을 동시에 학습해야 함

- 첫번째로 teacher는 task의 모든 파라미터를 구체화하고 난 후에 sparse 보상을 받음 → long-horizon credit assignment 문제 유발

- Curriculum Learning via Unsupervised Task Representation Learning (CLUTR)

- CLUTR의 핵심 → task representation 학습과 커리큘럼 학습을 분리하는 hierarchical graphical 모델

- Recurrent VAE를 학습하여 task manifold 학습

- 한번에 하나의 파라미터로부터 task를 생성하는 PAIRED와 다르게 CLUTR의 teacher는 latent task manifold로부터 task를 생성하고 생성 모델을 사용하여 이를 실제 완전한 task로 변환

- CLUTR teacher는 regret을 최대화하도록 사전 학습되고 고정된 task manifold를 탐험하면서 커리큘럼을 학습

- 사전 학습된 latent task manifold를 사용하여 CLUTR teacher는 single-step RL을 통해 학습될 수 있음 → long-horizon credit assignment 문제 극복 → 더 효율적으로 커리큘럼을 생성할 수 있고 효과에 대한 추가적인 cost 없이 안정성을 향상시킬 수 있음

- 추가적인 환경과의 상호작용 없이 학습에 대한 편향을 제공 (예를 들어 각 파라미터 벡터에 대해 정렬)하여 CLUTR는 조합 폭발 문제를 해결

- 마지막으로 teacher 모델에 상관없이 PAIRED에 제공되는 이론적인 강인성이 CLUTR에도 여전히 적용

- 본 실험의 결과를 통해 CLUTR가 PAIRED에 비해 일반화, 샘플 효율성 측면에서 우수한 성능을 보임 → 어려운 픽셀 기반의 연속적인 행동 환경인 CarRacing과 partially observable하고 벡터기반의 이산적인 행동 환경인 navigation 환경에서 검증

- 실험 결과: CarRacing의 경우

- CLUTR가 PAIRED에 비해 18배 높은 zero-shot 일반화를 달성 → 실제 F1 레이싱 트랙을 기반으로 모델링 된 F1 벤치마크에서 60% 적은 상호작용을 통해 학습 (샘플 효율성 향상)

- 게다가 CLUTR는 non-UED attention 기반 SOTA 알고리즘과 비교했을때도 유사한 성능을 보임 → 총 20개의 트랙 중 9개에서 좋은 성능을 보임 → 환경 상호작용은 1%보다 덜 요구됨

- 실험 결과: Navigation의 경우

- CLUTR가 18개의 테스트 task 중 14개에서 더 높은 zero-shot 일반화 성능 달성, 33% 더 높은 문제 해결률

- 본 논문의 Contribution

- PAIRED teacher를 강화한 새로운 UED 알고리즘 제안 → 커리큘럼 학습을 위한 hierarchical graphical 모델로부터 얻어진 unsupervised task-representation 학습

- CLUTR는 task representation 학습을 커리큘럼 학습으로부터 분리하여 PAIRED에 있었던 long-horizon credit assignment problem과 조합 폭발 문제를 해결

- 본 논문의 결과는 CLUTR가 PAIRED를 일반화 성능과 샘플 효율성 모두에서 더 좋은 성능을 보인다는 것을 확인 → CarRacing과 navigation 문제에서 검증

2. Background

2.1. Unsupervised Environment Design (UED)

- UED: free parameters로 덜 구체적으로 정의된 환경을 구체적이고 완전히 정의된 환경 분포로 디자인하여 커리큘럼을 유도하는 문제

- 완전히 정의된 환경은 Partially Observable Markov Decision Process (POMDP)로 정의할 수 있으며 다음으로 표현할 수 있음 → (A,O,S,T,I,R,γ)

- A,O,S는 행동, 관측, 상태 공간

- I→O: 관측함수

- R:S→R: 보상함수

- T:S×A→△(S): transition 함수

- γ: 감가율

- 구체화되지 않은 환경은 Underspecified Partially Observable Markov Decision Process (UPOMDP)로 정의하고 다음으로 표현 → M=(A,O,Θ,SM,TM,IM,RM,γ)

- Θ: 환경의 free 파라미터 셋

- TM:S×A×Θ→△(S)

- 값을 →θ에 할당하면 결과적으로 일반 POMDP이 됨 → i.e. UPOMDP + →θ = POMDP

2.2. PAIRED

- PAIRED는 세개의 플레이어들이 존재하는 적대적인 게임을 하는 UED를 푸는 기법

- agent (πP)와 antagonist (πA)는 teacher ˜θ에 의해 생성된 task에서 학습

- PAIRED의 목적함수

- 여기서 Regret은 생성된 task에서 antagonist와 에이전트에 의해 얻어지는 감가된 보상의 차이로 생성 → REGRETθ(πP,πA)=Vθ(πA)−Vθ(πP)

- 왜 Antagonist의 반환값이 항상 높을 수 있나? → teacher가 antagonist의 policy에 맞게 문제를 만들면 되기 때문 → 너무 어려우면 antagonist가 못풀고 너무 쉬우면 agent가 쉽게 풀어버리니까 아슬아슬하게 문제의 난이도에 대한 경계를 만들어낼 수 있음

- PAIRED의 teacher 에이전트는 다음과 같이 정의: Λ:Π→△(ΘT)

- Π: 가능한 에이전트들의 정책들의 세트, ΘT: 가능한 task들의 세트

- Teacher는 U를 보상으로 하여 강화학습 알고리즘을 학습, protagonist와 antagonist 에이전트는 환경으로부터의 일반적인 감가된 보상을 사용하여 학습

3. Curriculum Learning via Unsupervised Task Representation Learning

3.1. Formulation of CLUTR

- CLUTR의 핵심은 latent task manifold를 표현하는 latent 생성 모델

- CLUTR을 공식화하기 위해 Figure 1의 graphical 모델을 사용

- z는 환경을 생성하는 latent random variable

- E,R은 관측된 변수들, z는 관측되지 않은 latent 변수

- R은 PAIRED나 DR (Domain Randomization)을 포함하는 다양한 UED 기법들에서 사용되는 measure가 될 수 있고 PAIRED에서 R은 REGRET을 의미

- 위의 graphical 모델을 사용하여 UED에 대한 variational formulation 수행

- 먼저 variational objective를 latent z에 대한 approximate posterior distribution과 true posterior distribution 사이의 KL-divergence로 정의, R,E는 주어짐

- 먼저 variational objective를 latent z에 대한 approximate posterior distribution과 true posterior distribution 사이의 KL-divergence로 정의, R,E는 주어짐

- 다음으로 ELBO를 다음과 같이 쓸 수 있고

- 이는 다음과 같이 근사할 수 있음

- 위의 ELBO는 CLUTR의 최적화 목적을 정의

- 앞에서 말한대로 UED teacher는 커리큘럼과 task representation을 동시에 학습해야한다는 점에서 학습이 어려움

- 본 논문에서는 CLUTR를 위한 두 단계의 최적화를 제안

- Unsupervised task representation 학습을 위해 VAE를 미리 학습함

- 그리고 representation은 고정한 상태로 커리큘럼을 생성할 regret을 최적화

3.2. Unsupervised Latent Task Representation Learning

- 위에서 이야기한대로 본 논문에서는 latent task manifold를 생성하는 모델로 Variational AutoEncoder (VAE)를 사용

- Task θ를 정수의 시퀀스로 표현

- 예를 들어 navigation task에서 해당 정수들은 장애물, 에이전트, 골의 위치를 나타냄

- LSTM 기반의 Recurrent VAE를 사용하여 정수 시퀀스로부터 task representation을 학습

- 각 정수에 대한 임베딩을 학습하고 시퀀스들에 대해 cross-entropy를 사용하여 reconstruction loss를 도출

- 이런 구조에 대한 선택은 CLUTR가 정수 시퀀스를 넘어서는 task parameterization에도 적용가능하도록 함 (e.g. 문장, 이미지)

- VAE를 학습하기 위해서 ΘT (가능한 task들의 세트)로부터 균일하게 샘플링하여 랜덤 task를 생성

- 그러므로 task manifold의 학습을 위해서 환경과의 상호작용을 요구하지 않음

- 환경/시뮬레이터와의 상호작용은 샘플링에 비해 훨씬 비용이 많이 요구됨 → 이런 task manifold에 대한 unsupervised 학습은 사용하기에 굉장히 실용적

- 게다가 이 입력 시퀀스들이 permutation invariant한 경우 전체적으로 혹은 부분적으로 정렬 → 학습 시퀀스들을 정렬함으로써 PAIRED teacher에서 문제가 되었던 순열 폭발 문제를 피할 수 있음

- 왜 해결이 된다는걸까? → 일부 파라미터들의 경우는 (1,2,3), (3,2,1)이 같을 수 있음 → 이에 대한 정렬을 통해서 조합의 수를 줄인다는 의미로 해석됨 → 하지만 아직 의문인건 이거는 VAE로 해결된게 아닌 것 같은데?

3.3. CLUTR

- 식 (1)에서 주어진 목적함수를 통해 CLUTR 정의

- CLUTR는 PAIRED와 동일한 커리큘럼 목적함수 사용

- REGRET(R,E)=REGRETθ(πP,πA), θ는 task → i.e. 환경 E의 free 파라미터에 구체적인 값을 할당

- 직접적으로 θ를 생성하는 PAIRED teacher와 다르게 CLUTR teacher의 정책은 다음과 같이 정의 → Λ:Π→△(Z)

- Π: 가능한 에이전트의 정책들, Z: latent 공간

- 그러므로 CLUTR teacher는 random z를 샘플링하여 latent를 생성 → θ는 VAE decoder에 의해 생성 → g:Z→Θ

- CLUTR의 알고리즘

- 이제 PAIRED의 변형들과 비교했을 때 CLUTR의 몇가지 추가적인 특성들에 대해 살펴볼 것

- CLUTR teacher는 latent 공간 Z로부터 샘플 → single step RL을 통해 학습 → PAIRED나 REPAIRED의 경우 teacher가 single step RL을 통해 학습하는 것이 불가능 → 부분적으로 생성된 task의 상태에 따라 한번에 하나의 task 파라미터를 생성하기 때문

- 왜 CLUTR만 single step RL이 된다는걸까?? → 추정: PAIRED의 경우 task representation이 계속 학습되므로 강화학습 입장에서는 상태가 계속 달라지는 느낌이지만 CLUTR의 경우는 VAE를 통해서 각 task에 대한 representation을 고정했으므로 같은 디자인에 대해 상태가 달라지지 않으므로 single step RL이 적용 가능하다

- PAIRED의 변형들은 다른 환경에 대해 다른 teacher 구조를 디자인해야함 → POMDP의 상태 공간에 의존 → CLUTR teacher의 구조는 POMDP나 UPOMDP여도 상관이 없음 → 그러므로 동일한 구조가 여러 다른 문제에 걸쳐 사용될 수 있음

- CLUTR는 가능한 에이전트의 정책들의 세트 Π에 대해 어떤 가정도 부과하지 않음 → 그러므로 CLUTR는 PAIRED와 동일한 강인성이 보장됨

- CLUTR teacher는 latent 공간 Z로부터 샘플 → single step RL을 통해 학습 → PAIRED나 REPAIRED의 경우 teacher가 single step RL을 통해 학습하는 것이 불가능 → 부분적으로 생성된 task의 상태에 따라 한번에 하나의 task 파라미터를 생성하기 때문

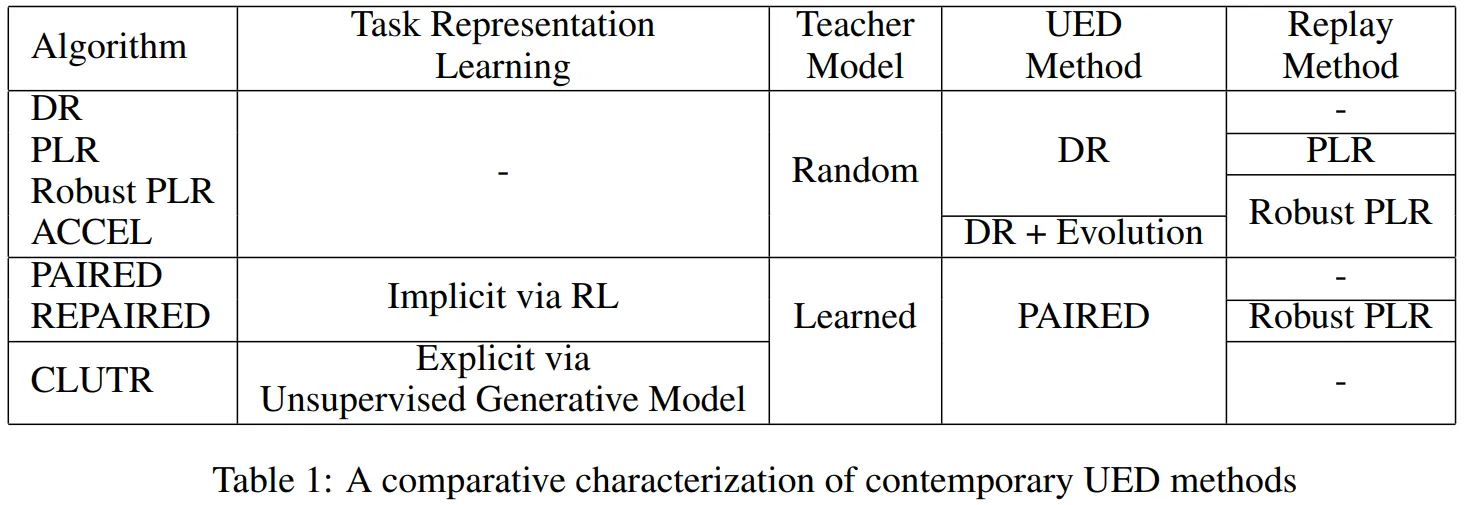

3.4. Comparison of CLUTR with Contemporary UED Methods

- 현재의 UED 기법들은 다음과 같은 특징들을 가짐

- Teacher type: random/fixed or learned/adaptive

- Replay의 사용

- 현재 UED의 관점에서 CLUTR을 보았을 때 커리큘럼 학습 알고리즘이라는 또 다른 중요한 면에서의 논의가 필요

- 랜덤 UED teacher는 task manifold를 학습하지 않음

- PAIRED나 REPAIRED와 같은 regret 기반 teacher들

- implicit하게 학습 (e.g. teacher LSTM의 hidden state)

- task에서 생성한 regret 추정을 기반으로 강화학습을 사용하여 학습

- task-manifold는 REGRET 추정의 품질에 의존

- CLUTR의 경우

- VAE에 의해 모델링 된 explicit task manifold를 사용

- task의 유사도를 파악할 수 있는 local neighborhood structure를 나타낼 수 있음

- 이 local neighborhood structure는 teacher가 manifold를 탐험하는 것을 용이하게 해야함

- 위의 내용을 통해 CLUTR이 PAIRED 및 REPAIRED와 함께 random generation 기반 기법들과 반대되는 학습된 task manifold를 기반으로 task를 생성하는 UED의 한 종류라는 것을 알 수 있음 → 하지만 이 중에서도 CLUTR는 유일하게 unsupervised generative task manifold를 사용하는 기법

4. Experiments

- 성능 비교 알고리즘: PAIRED, REPAIRED

- 성능 비교 환경

- CarRacing: dense 보상을 가지는 연속적인 행동 환경

- Navigation: sparse 보상을 가지는 이산적인 행동 환경

- 실험을 통해 가설들에 대한 성능 검증을 진행

- CLUTR는 regret 기반의 teacher를 쉽게 학습할 수 있게 만들어줌 (Section 4.3)

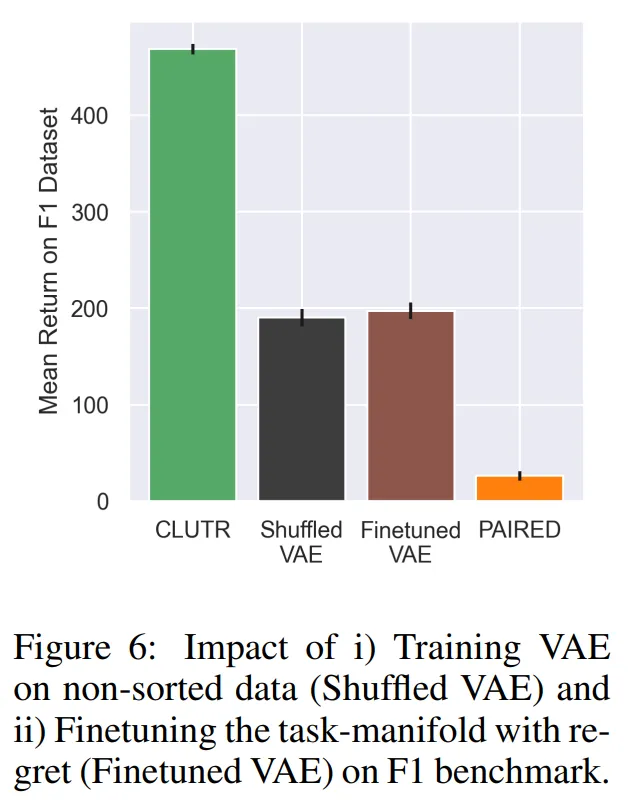

- Task representation과 커리큘럼을 동시에 학습하는 것은 성능을 저하시킴 (Section 4.4)

- 정렬된 데이터에 대한 VAE 학습은 조합 폭발 문제를 해결함 (Section 4.5)

- 마지막으로 CLUTR와 PAIRED의 커리큘럼을 분석적으로 비교

4.1. CLUTR Performance on Pixel-based Continuous Control CarRacing Environment

- CarRacing 환경 → 에이전트가 Bezier curve로 모델링 된 폐곡선의 레이싱 트랙 한바퀴를 돌 수 있도록 운전을 해야함

- 학습 관련 설정

- 백만개의 랜덤하게 생성된 트랙을 통해서 백만번 gradient update를 수행하며 학습

- CLUTR는 2백만 타임 스텝동안 학습 → 에이전트의 학습이 반환값이 최대값에 수렴할 때까지

- 검증 관련 설정

- F1 benchmark에서 검증 수행 → 실제 F1 레이싱 트랙으로 모델링 된 20개의 테스트 트랙

- 이 트랙들은 오직 12개의 제어 요소들로 UED teacher가 생성하는 트랙들에 비하면 굉장히 out-of-distribution된 트랙들

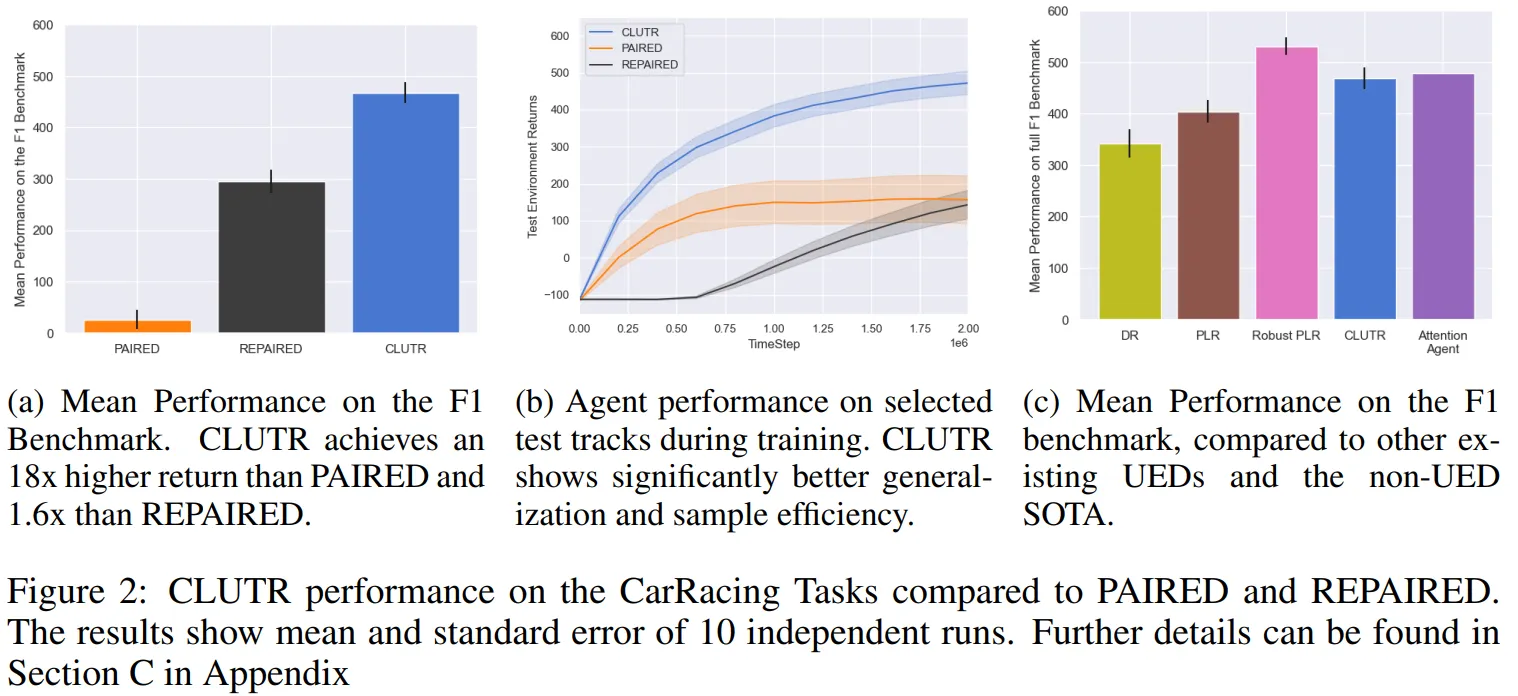

- Figure 2a는 20개의 F1 테스트 트랙에서 CLUTR, PAIRED, REPAIRED에서 얻어진 평균 반환값을 보여줌 → 학습 성능 비교

- CLUTR은 굉장한 차이로 PAIRED와 REPAIRED에 비해 좋은 성능을 보임 → 20개의 테스트 트랙에 대해 PAIRED와 비교했을때는 18배 더 높은 반환값을, REPAIRED와 비교했을때는 1.6배 더 높은 반환값을 보임

- 또한 CLUTR의 경우 오직 2백만 스텝만 학습을 수행하고 PAIRED와 REPAIRED의 경우 5백만 스텝 동안 학습 수행

- Figure 2b는 4개의 본적 없는 트랙 (Vanilla, Singapore, Germany, Italy) 에서의 일반화 성능을 나타냄

- 선택된 트랙들에서 CLUTR는 훨씬 좋은 일반화 성능과 샘플 효율성을 보임

- 또한 CLUTR를 다른 기존 UED 기법들과도 비교 → Figure 2c

- CLUTR는 Domain Randomization과 PLR보다 좋은 성능을 보이고 Robust PLR에 비해서는 조금 떨어지는 성능을 보임 (전체적으로 약 1.13배 더 높은 반환값을 달성)

- 그럼에도 불구하고 CLUTR는 20개 중 7개의 트랙에서 Robust PLR과 유사한 성능을 보이며 하나의 트랙에서는 더 좋은 성능을 보여줌

- 게다가 CLUTR는 CarRacing에서 SOTA 기법인 non-UED attention 기반 기법과 동등한 성능을 보임 (20개 중 9개에서 CLUTR가 더 좋은 성능) → CLUTR의 경우 self-attention도 사용하지 않고 훨씬 적은 시간 스텝 동안만 학습 (<1%)

4.2. CLUTR Performance on Partially Observable Navigation Task on MiniGrid

- 또한 CLUTR와 PAIRED의 성능을 유명한 MiniGrid 환경에서 비교

- 해당 환경은 navigation task로 에이전트는 장애물을 피해서 골에 도달해야하는 sparse 보상 환경

- 학습 관련 설정

- CLUTR VAE의 학습을 위해 백만개의 랜덤 grid 생성 → 장애물 위치는 정렬, 장애물의 수는 0 ~ 50개까지 다양하게 사용

- PARIED와 CLUTR 모두 500M 시간 스텝 동안 학습 (기존 PAIRED 논문에서는 3B 동안 학습)

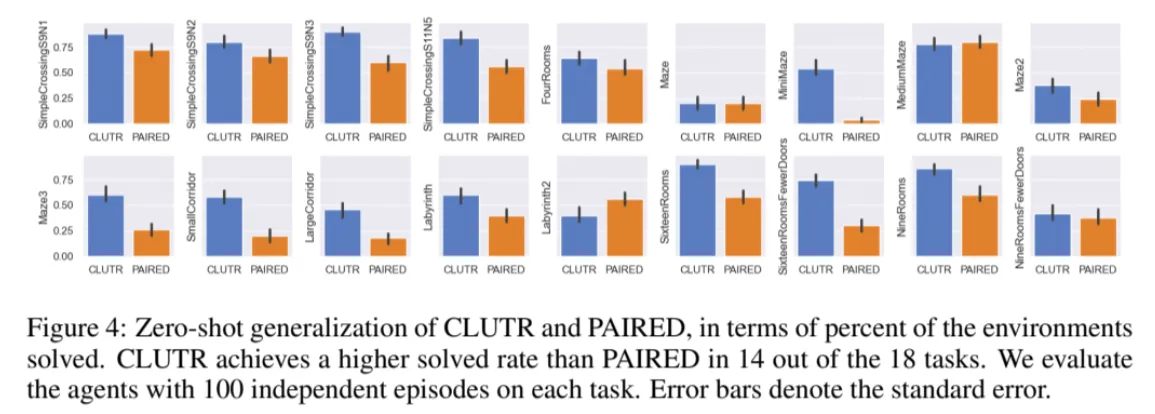

- Figure 4는 18개의 본적 없는 navigation task에서 CLUTR와 PARIED의 zero-shot 일반화 성능을 비교

- 본적 없는 grid에서 PAIRED의 경우 43%, CLUTR의 경우 64%의 해결율을 보이며 더 뛰어난 일반화 성능을 보임

- CLUTR의 경우 18개의 테스트 navigation task 중 14개에서 PAIRED와 비교했을 떄 더 높은 해결율을 보임

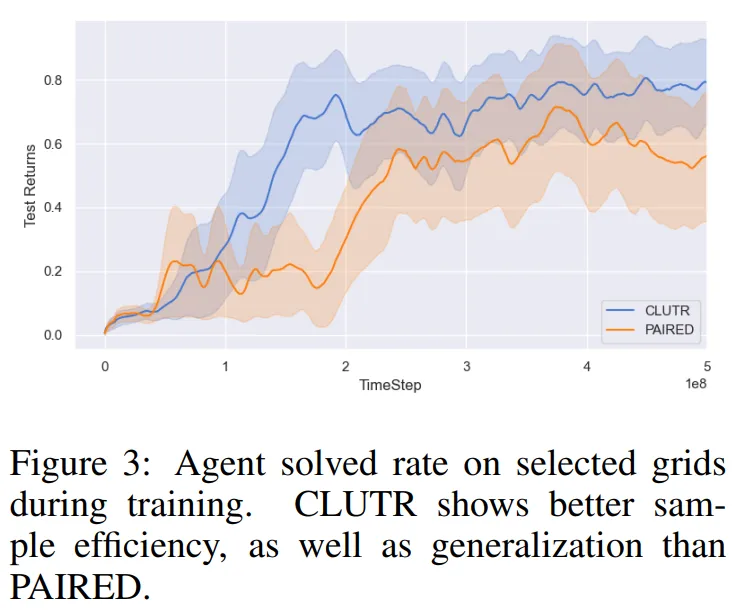

- Figure 3은 4개의 선택된 grids에 대한 return을 보임

- 4개의 grid: Sixteen Rooms, Sixteen Rooms with Fewer Doors, Labyrinth, Large Corridor

- CLUTR가 PAIRED에 비해 더 좋은 샘플 효율성과 일반화 성능을 보임

4.3. Teacher Training Performance: CLUTR vs. PAIRED

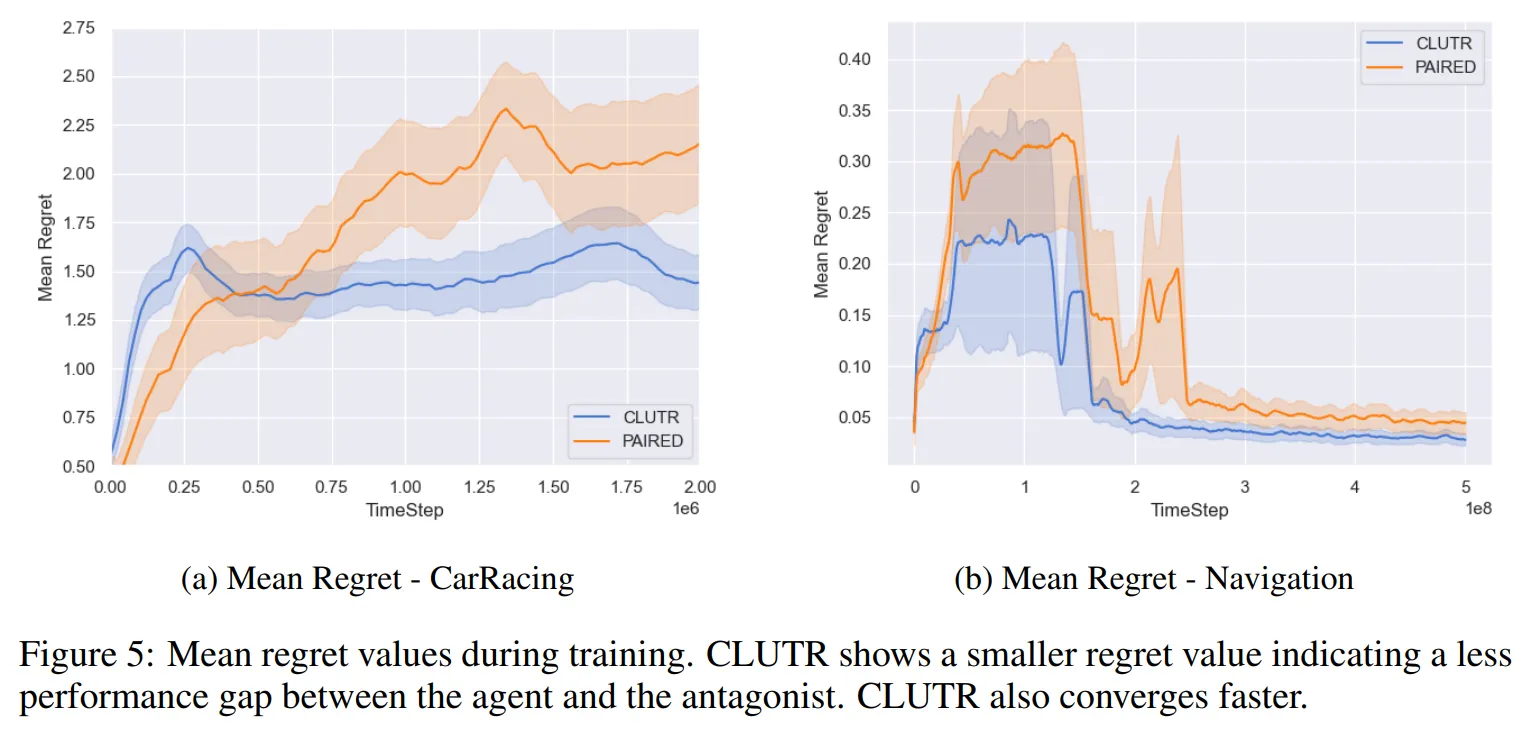

- Figure 5는 CarRacing과 navigation task에서 teacher가 생성한 tasks에서 평균 regret을 보여줌

- CLUTR가 PARIED에 비해서 더 낮은 regret을 보임 → 에이전트와 antagonist 사이의 성능 차이가 CLUTR에서 더 적음

- 커리큘럼의 관점에서 우리는 에이전트가 이미 풀 수 있는 것 보다 약간 더 어려운 task에서 학습하는 것을 원함

- 에이전트와 antagonist는 모두 동일한 조건에서 학습 → 동일한 하이퍼파라미터, 모델 구조, task를 가지고 오직 random initial weight만 다음

- 더 낮은 regret이 의미하는 것

- teacher가 지금 에이전트가 풀 수 있는 문제보다 약간 더 어려운 task를 생성 (왜냐면 다른 에이전트는 풀고있기 때문에)

- 혹은 antagonist가 약간 더 잘하고 있는 task를 생성

- 해당 그래프에서 CLUTR와 PARIED가 유사한 수렴 패턴을 보이는 것을 확인 → 하지만 CLUTR가 더 빠르게 local optimum으로 수렴 → CLUTR의 teacher가 PAIRED의 teacher보다 학습이 쉬움을 의미

4.4. Learning Task Manifold and Curriculum: Joint vs Two-staged Optimization

- task manifold의 non-stationary 때문에 task representation 학습과 curriculum을 동시에 학습하는 것은 학습이 어려움

- 이를 테스트하기 위해 task representation은 고정해두고 teacher-student 커리큘럼 학습 과정 동안 regret loss에 대해 decoder를 finetuning

- 해당 실험은 F1 benchmark에서 58%의 성능 저하를 보임 → Figure 6의 “Finetuned VAE”

- 이를 통해 경험적으로 다음의 가설을 검증함 → latent task space를 미리 학습하고 이를 탐험하면서 커리큘럼 학습하는 것이 커리큘럼 학습을 쉽게 하며 더 좋은 UED 성능을 보임

4.5. Impact of Sorting VAE Data on Solving Combinatorial Explosion

- VAE에 대한 sorted sequences를 학습하는 것이 조합 폭발 문제를 해결할 수 있다는 가설에 대한 검증 수행

- CLUTR를 5배 더 길고 non-sorted된 VAE로 기존 데이터셋보다 10배 더 큰 버전으로 학습

- F1 벤치마크에서 59% 성능 하락 → Figure 6의 “Shuffled VAE”

4.6. Curriculum Complexity

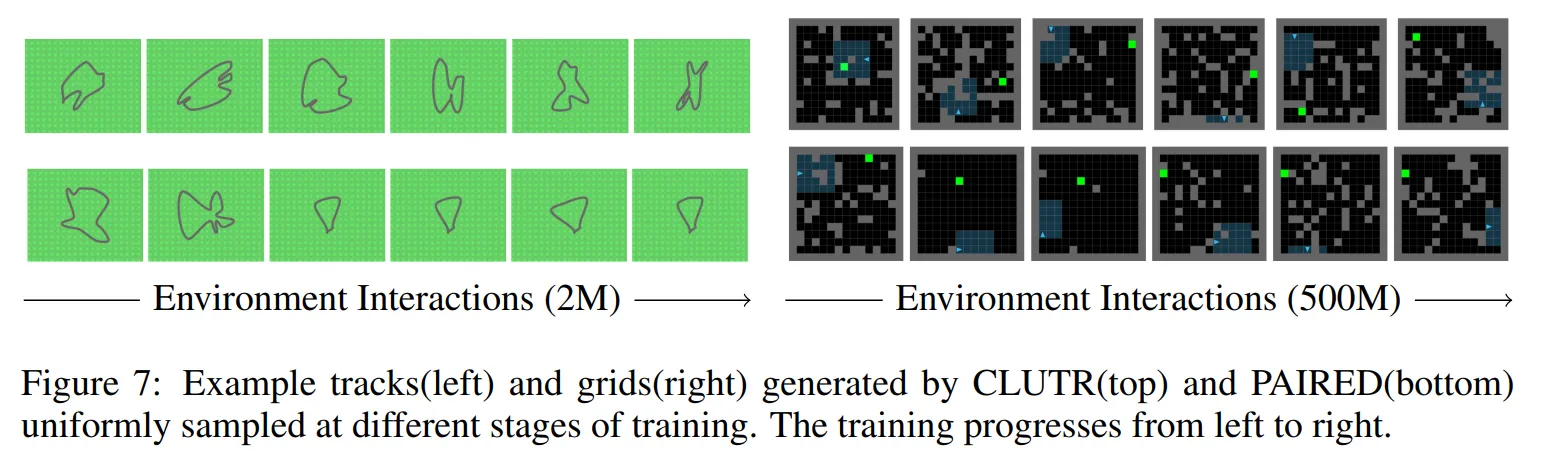

- CLUTR와 PAIRED에서 생성된 커리큘럼 비교 (Figure 7)

- PAIRED에서 보이는 실패나 비효율적인 사례를 살펴볼 수 있음

- 커리큘럼이 복잡한 task에서 시작 → 에이전트가 학습 초기 단계에서 풀 수 없음

- 시간이 어느정도 지난 후 PAIRED는 퇴보한 task를 생성하기 시작 → 충분한 학습이 주어지면 PAIRED는 마침내 퇴보한 local minima에서 빠져나와 커리큘럼을 위한 환경을 제작하기 시작

- 반면에 CLUTR는 이런 퇴보 과정을 보이지 않고 흥미로운 task들을 생성하는 것을 볼 수 있음

5. Conclusion and Future Work

- 본 논문에서는 unsupervised task representation 학습을 통한 환경 디자인 기법을 제안

- CLUTR는 latent task space를 사용하며 task representation 학습과 커리큘럼 학습을 분리하는 방식으로 PAIRED를 보강

- CLUTR는 PAIRED 변형 기법들에 비해 몇가지 장점을 보임

- long-horizontal credit assignment 문제 해결

- 파라미터 공간에서 combinatorial explosion 해결

- 실험 결과를 통해 CLUTR가 PARIED 변형 기법들에 비해 샘플 효율성, 일반화 측면에서 좋은 성능을 보임

- CLUTR의 한계점

- 사람 수준의 task structure는 잘 만들지 못함

- Multi-atent RL의 경우 Nash equilibrium에 도달해야만 수렴에 대한 이론적 보장을 하지만 실제적으로 deep multi-agent RL은 수렴을 보장하지 못함

- Regret 예측이 나쁘면 나쁜 커리큘럼 학습으로 이어짐

'논문 리뷰 > Reinforcement Learning' 카테고리의 다른 글

| Collaborating with Humans without Human Data (8) | 2024.11.15 |

|---|---|

| Deep Reinforcement Learning from Human Preference (3) | 2024.11.10 |

| BYOL-Explore: Exploration by Bootstrapped Prediction (4) | 2024.11.03 |

| Planning with Diffusion for Flexible Behavior Synthesis (0) | 2024.11.03 |

| Estimating Risk and Uncertainty in Deep Reinforcement Learning (0) | 2024.11.03 |